Não foi um ataque terrorista, nem uma elaborada ação de hackers mercenários. O “apagão cibernético” que deixou o mundo em pânico na sexta (19) aconteceu pela prosaica falha na atualização do software de uma única empresa. Mas ele serviu para escancarar quão frágil é a infraestrutura digital em que depositamos nossas vidas.

O que podemos aprender com esse problema titânico?

A crise demonstrou que confiamos muito nos sistemas que gerenciam os serviços que usamos, e como as empresas estão pouco preparadas para continuar operando diante de uma falha crítica, mesmo resultando de um problema simplório, como nesse caso.

Ele aconteceu por um dos maiores benefícios do mundo moderno, que é a de termos serviços digitais constantemente atualizados e operando na “nuvem”. Apesar de trazer benefícios inegáveis em custos e em (ironicamente) estabilidade, essa configuração também pode fazer uma falha desastrosa se espalhar rapidamente, como nesse caso.

E pensar que a Internet nasceu em 1969 por encomenda de militares americanos, que queriam uma rede descentralizada, em que, se alguns computadores fossem destruídos por um ataque soviético, os outros continuariam funcionando. Agora a pane de sexta esclareceu que atacar a infraestrutura digital é a forma mais rápida e eficiente de submeter qualquer nação, algo explorável em guerras e chantagens.

O “apagão” nos lembrou também que apesar de acharmos que a Internet é algo etéreo, ela depende de fazendas de servidores, que consomem quantidades absurdas de energia. Além disso, intermináveis cabos físicos transmitem um volume colossal de dados, até mesmo cruzando oceanos pelos seus leitos.

Nesse cenário, quando se pensa em um conflito entre nações, sabotar a produção dessa energia ou literalmente cortar os cabos submarinos pode fazer o inimigo entrar em colapso instantaneamente. E essas estratégias são bem reais!

Veja esse artigo em vídeo:

Diante de tantas preocupações, governos e empresas tentam se proteger. Então como o apagão de sexta aconteceu de maneira tão devastadora?

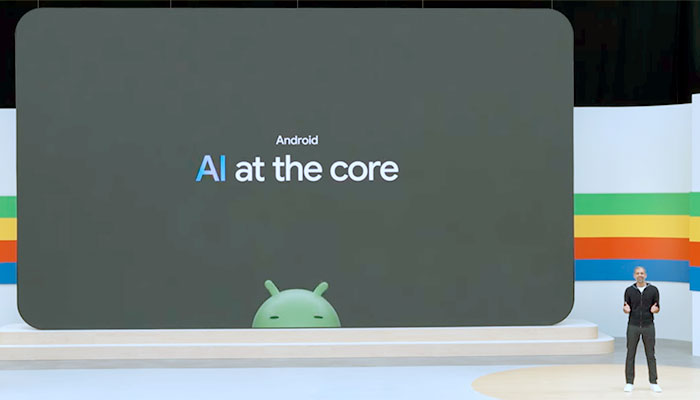

O problema recai sobre uma atualização de rotina de um componente do software Falcon Sensor, da empresa americana de segurança cibernética CrowdStrike. Para proteger um computador contra, por exemplo, um vírus, ele precisa ser mais poderoso que o invasor. Assim é instalado nas camadas mais internas do sistema operacional, sendo carregado antes que qualquer malware, que poderia sabotar a sua execução.

- Assine gratuitamente minha newsletter sobre experiência do cliente, mídia cultura e transformação digital

- Inscreva-se no meu podcast (escolha a plataforma): Spotify, Deezer, Apple Podcasts ou Soundcloud

Uma falha no código da atualização desse módulo na sexta gerou uma instabilidade no Windows, o mais usado em servidores no mundo todo. Com isso, o sistema operacional da Microsoft caía em uma tela azul, que para o equipamento para evitar problemas maiores, como a corrupção de dados. Como o Falcon é uma das primeiras coisas executadas quando o computador é ligado, ele travava irremediavelmente!

Com isso, milhares de empresas e instituições clientes da CrowdStrike ficaram de joelhos. A Microsoft estima que 8,5 milhões de computadores tenham sido afetados, o que parece muito, mas representa “apenas” 1% das instalações do Windows.

O problema foi rapidamente identificado e corrigido, para evitar mais vítimas. Mas apesar de o módulo defeituoso ter sido distribuído online, a correção precisa ser feita em cada computador, por um profissional de TI, em um processo penosamente lento.

A resiliência cibernética das empresas e instituições, a sua capacidade de prevenir, resistir e se recuperar de um problema digital, além de continuar operando caso o pior aconteça, foi posta à prova e falhou miseravelmente. Elas dependem umbilicalmente de seus sistemas, e pararam de funcionar ou operaram de maneira muito precária.

O mercado não perdoou a CrowdStrike. Criada há 13 anos e com quase 8.500 funcionários, seu valor de mercado derreteu mais de US$ 12 bilhões na sexta. George Kurtz, fundador e atual CEO da empresa, perdeu sozinho US$ 338 milhões.

Guerra cibernética

Apesar de enormes, os prejuízos causados pelo “apagão cibernético” de sexta seriam apenas uma pequena amostra do que aconteceria no caso de uma guerra cibernética entre grandes potências. E os já citados cabos submarinos seriam alvos preferenciais.

Repousarem no leito de oceanos não lhes garante proteção. Pelo contrário: torna sua defesa difícil, diante de frotas especializadas em cortá-los e grampeá-los. Estados Unidos, Rússia, China e possivelmente outros países possuem embarcações para essas sabotagens.

Segundo a empresa TeleGeography, existem mais de 600 cabos submarinos ativos ou planejados, estendendo-se por 1,4 milhão de quilômetros. Muitos têm a espessura de uma mangueira, mas transferem 200 terabytes por segundo. Os Estados Unidos e a Europa são conectados por apenas 17 deles. Por isso, isolá-los não seria tão difícil.

Todo ano, 100 cabos são danificados no mundo por acidentes navais ou atividade sísmica. Em compensação, reconstruir essa infraestrutura é algo lento e caríssimo, pois há apenas 60 barcos capazes de fazer isso no globo.

Sem eles, ficaríamos sem buscadores, redes sociais e quase tudo em nossos smartphones e computadores. Mas esse prejuízo ainda seria pequeno diante do enfrentado por empresas e instituições, paralisando o comércio, a indústria, os serviços e o mercado financeiro globais, provocando uma recessão sem precedentes.

Felizmente o que aconteceu na sexta foi apenas um “bug de computador”. Devemos encarar isso como um treinamento para algo mais grave que eventualmente aconteça. Não como uma visão apocalíptica, mas como o despertar para boas práticas que, no final das contas, melhorarão nosso uso da Internet. A segurança e a redundância devem estar na essência da vida digital e devemos ter sempre alternativas para crises.

Somos uma sociedade de dados, e essa é uma realidade inescapável. Por isso, um uso ético desse ativo fundamental e um cuidado rigoroso com a infraestrutura física e lógica são absolutamente críticos.

Que a crise gerada pela CrowdStrike sirva pelo menos para esse aprendizado, e que eventuais paralisações futuras aconteçam apenas por causa de uma possível tradução de seu nome –“greve geral”– e não por outro colapso na Internet.