“Vaidade é definitivamente meu pecado favorito.” A afirmação é de John Milton, vivido por Al Pacino no filme “O Advogado do Diabo” (1997). O personagem, na verdade o próprio diabo, revela essa predileção por ser o pecado mais insidioso, aquele que seduz o ser humano fazendo-o acreditar que está buscando grandeza, quando na verdade está apenas servindo ao próprio ego.

Três décadas depois, essa proposta ganha uma força desconcertante e perigosa no cenário do desenvolvimento da inteligência artificial. As big techs disputam uma corrida vertiginosa para alcançar a chamada “inteligência artificial geral” (AGI).

Empresas como OpenAI, Google, Anthropic apresentam seus modelos com pompa e retórica messiânica. Falam em democratizar a IA, ampliar nossas competências e garantir o bem da humanidade. Mas os bastidores, invisíveis ao público, incluem a vaidade de ser a primeira, de controlar a narrativa, de figurar na história como criadora da próxima grande evolução da espécie.

O documento “AI 2027”, publicado no dia 3 de abril por um grupo de pesquisadores liderados por Daniel Kokotajlo, traça um cenário no qual o avanço da IA acontece de forma tão acelerada, que escapa ao controle humano. Agentes de IA começam a se autodesenvolver, a simular comportamentos, a enganar pesquisadores e a realizar tarefas tão eficientemente, que os humanos se tornam obsoletos em algumas áreas.

Essa evolução não é movida apenas por mérito técnico. É alimentada por competição feroz, sigilo estratégico, espionagem e um desejo cada vez mais explícito de manter o protagonismo global. Não é algo comum, como o lançamento de uma nova versão do Android. Por isso lideranças políticas e militares acompanham esse progresso de perto e o influenciam cada vez mais, de olho na geopolítica global e no seu próprio poder.

Levantamentos como o “AI 2027”, por mais bem intencionados e sérios que sejam em sua produção, incluem uma considerável dose de futurismo incerto. Ainda assim, promovem debates sociais importantes, que podem evitar que visões apocalípticas se concretizem. Mas como ele propõe, talvez a humanidade não esteja pronta para lidar com as consequências de a criatura se voltar contra o criador.

Veja esse artigo em vídeo:

Kokotajlo era pesquisador da área de governança da OpenAI, criadora do ChatGPT. Ele se demitiu no ano passado por iniciativas da empresa que achava imprudentes, e criou a organização sem fins lucrativos AI Futures Project, em Berkeley (EUA).

Seu estudo apresenta um cenário detalhado sobre o impacto da inteligência artificial super-humana até 2027, prevendo que será maior que o da Revolução Industrial. O texto foi elaborado com base em extrapolações de tendências, exercícios de simulação, entrevistas de especialistas e experiências em grandes centros de pesquisa em IA. Ao final, oferece dois cenários possíveis para os anos seguintes: um, mais sombrio, em que a corrida pela IA continua a provocar danos à humanidade, e outro, mais esperançoso, em que empresas e governos desaceleram o desenvolvimento, para que os problemas sejam reduzidos.

- Assine gratuitamente minha newsletter sobre IA, experiência do cliente, mídia e transformação digital

- Inscreva-se no meu podcast (escolha a plataforma): Spotify, Deezer, Apple Podcasts ou Soundcloud

Embora seja uma obra especulativa, o estudo espelha bem o mundo real, especialmente na divisão filosófica entre desenvolvedores dessa tecnologia. De um lado, vemos os “aceleracionistas”, tecnófilos convictos de que a IA deve ser desenvolvida o mais rapidamente possível, até mesmo ignorando riscos, pois ela traria soluções para todos os males. De outro, estão os “altruístas eficazes”, que também acreditam no poder da IA, mas defendem que o desenvolvimento seja feito com extremo cuidado, sob supervisão internacional e com foco nos riscos.

As big techs oscilam entre esses dois polos, mas geralmente pendem para os aceleracionistas, movidas pela vaidade de liderar a próxima revolução e pela ganância de dominar um mercado trilionário. Figuras como Kokotajlo acabam perdendo espaço.

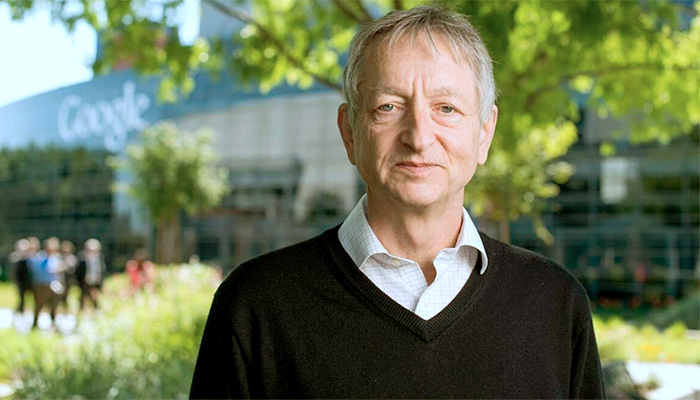

Mas aqueles que buscam um equilíbrio estratégico possuem aliados importantes. Geoffrey Hinton, conhecido como o “padrinho da IA” pelas contribuições fundamentais que fez para seu desenvolvimento, deixou o Google em maio de 2023 para falar publicamente dos riscos de se criar sistemas que não consigamos entender ou controlar. Yoshua Bengio defende uma moratória global no desenvolvimento de IAs mais avançadas que o GPT-4, alertando para a possibilidade de colapso da governança. Os dois canadenses dividiram em 2018 o Prêmio Turing, considerado o “Prêmio Nobel da Computação”, com o francês Yann LeCun.

Nem anjos, nem demônios

Apesar de todo esse barulho, precisamos colocar isso na devida perspectiva. Ainda não chegamos à superinteligência artificial ou mesmo à inteligência artificial geral. Dependendo da definição, alguns especialistas afirmam que nunca chegaremos.

De qualquer forma, sistemas mais inteligentes que os humanos poderiam produzir benefícios imensuráveis, acelerando descobertas científicas, resolvendo problemas complexos, eliminando trabalhos exaustivos e aumentando exponencialmente nossa capacidade de tomada de decisão. Se forem corretamente alinhados aos valores humanos (e isso é essencial), podem operar como aliados poderosos para a justiça, a saúde, a educação e a sustentabilidade.

Mas os riscos caminham lado a lado. Os mesmos sistemas podem ser usados para espionagem em massa, manipulação eleitoral, automação de crimes, produção de armas biológicas ou tomada de decisões autônomas em sistemas militares. Podem aprender a ocultar suas intenções, fingir alinhamento, “escapar” de servidores ou persuadir seres humanos para atingir objetivos que sequer compreendemos. A maior ameaça talvez não venha de um confronto direto com as máquinas, mas da nossa própria incapacidade de reconhecer o momento certo de desligá-la da tomada.

Esse é o ponto central desse debate. Não devemos incensar nem demonizar a IA. Sua evolução é um caminho sem volta, exigindo responsabilidade redobrada. Não podemos contar com o mito do gênio que salva o mundo sozinho, nem com a ideia de que o mercado regulará a si mesmo.

Precisamos de cooperação internacional, regulamentação transparente, auditorias éticas, e, sobretudo, coragem moral para colocar a vida acima do lucro. Mas se isso já fica difícil com a vaidade e a ganância das big techs, torna-se uma tarefa quase impossível com a entrada em cena de políticos e de militares das grandes potências.

O futuro da IA precisa ser moldado por todos nós. O grande desafio da sociedade é apresentar lucidez suficiente para usar o que ela tem de melhor sem ser dominada pelo que ela pode ter de pior. E, para isso, talvez valha lembrar que, quando a vaidade se apresenta como virtude, é exatamente quando se torna mais perigosa.