Não cansamos de nos deslumbrar com as capacidades da inteligência artificial generativa. Quando foi apresentado no dia 13 de maio, o GPT-4o, versão mais recente do “cérebro” do ChatGPT, parecia mágico, com suas capacidades cognitivas refinadas e conversas bem-humoradas. Mas ironicamente, apesar de essa data estar associada à lei que formalizou o fim da escravidão no Brasil, o “milagre da IA” das grandes empresas de tecnologia depende de um trabalho muitas vezes estressante e mal remunerado, feito por uma multidão de pessoas subcontratadas em países pobres.

Conhecidos como “data taggers” (ou “rotuladores de dados”), esses trabalhadores desempenham o papel crucial de ajudar os modelos de IA no que eles não conseguem distinguir por conta própria, de modo que, a partir daquela informação, eles saibam decidir corretamente. Por exemplo, em um conjunto de fotos, o que é um gato, um tigre, um leão e um cachorro? Um texto está com linguagem jornalística, publicitária ou acadêmica? Uma foto apresenta uma mulher amamentando, um nu artístico ou não passa de pornografia?

São sutilezas fáceis para uma pessoa entender, mas impossíveis para uma plataforma digital ainda destreinada. Mas depois que o rotulador de dados explica o que cada coisa é para a máquina, ela passa a ser capaz de identificar padrões para que tome boas decisões no futuro.

Como se pode ver, as respostas da IA dependem desse trabalho para serem adequadas. E como a humanidade usa cada vez mais esses sistemas, o descuido com o processo e com as pessoas nessa etapa pode trazer impactos significativos em tudo que fazemos. Portanto, se essas pessoas atuarem em condições degradantes, podemos estar confiando nosso futuro a uma forma de precarização de trabalho que pode trazer perigosos impactos para todos.

Veja esse artigo em vídeo:

A IA precisa de uma quantidade brutal de dados na fase de seu treinamento para que funcione. Só assim ela consegue identificar padrões e criar vínculos entre elementos de informação para que tire suas conclusões depois. Nem todos esses dados passam por um processo de rotulação por humanos, mas os que passam são fundamentais para que o sistema desenvolva uma base sobre a qual trabalhará.

A rotulação pode ser feita por cientistas de dados ou profissionais especializados. Isso resulta em um modelo mais preciso, porém custa mais e demora para ser concluído. O custo e a qualidade podem cair com um serviço terceirizado, e caem muito mais no modelo de “crowdsourcing”. E esse último formato tem sido escolhido pelas big techs para rotular as bases de dados colossais de suas plataformas de IA. Com ele, a classificação de dados é transformada em uma infinidade de microtarefas.

- Assine gratuitamente minha newsletter sobre experiência do cliente, mídia cultura e transformação digital

- Inscreva-se no meu podcast (escolha a plataforma): Spotify, Deezer, Apple Podcasts, Google Podcasts ou Soundcloud

Você certamente já participou, sem saber, de inúmeras delas, quando precisou comprovar que era um ser humano. Essa tecnologia se chama reCAPTCHA, na qual ajudamos plataformas a identificar elementos em fotos ou palavras digitalizadas. Com isso, estamos rotulando dados para o sistema, que compara nossas respostas com a de muitos outros usuários para ter uma informação de qualidade.

Mas dizermos que partes de uma foto têm semáforos não é suficiente para treinar uma base como a que faz um ChatGPT funcionar. Para isso, um exército de pessoas subcontratadas por empresas especializadas realiza milhões dessas microtarefas.

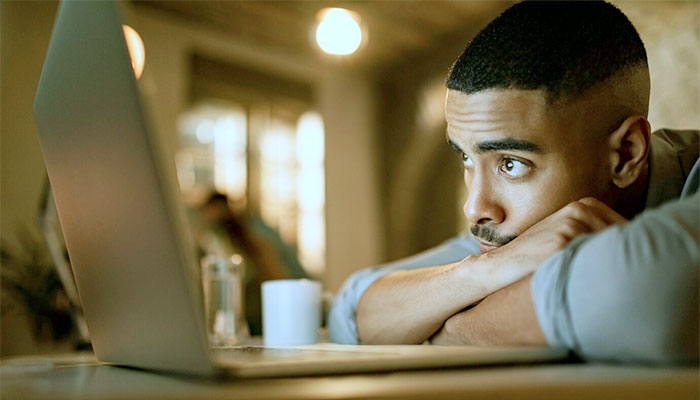

Elas não têm contato com outros indivíduos, trabalhando de casa e gerenciadas por um software. Tudo isso pode prejudicar a qualidade das entregas. Assim algumas técnicas são usadas para compensar isso e minimizar problemas, como interfaces intuitivas, a busca de um consenso na rotulação de vários profissionais para um mesmo conteúdo e uma auditoria dos rótulos, que verifica sua precisão.

Esses trabalhadores normalmente são pouco qualificados e vivem em países pobres, como Quênia ou Índia, recebendo apenas de US$ 1 a US$ 2 por hora. Pessoas nos EUA ou na Europa Ocidental não aceitam tão pouco. Mas, apesar de ser aviltante nessas regiões, esse valor pode ser significativo nas partes mais pobres do globo.

E aí reside uma perversidade no sistema. Quando precisam que alguma informação seja rotulada por um americano, por exemplo, a plataforma paga muito mais pela mesma tarefa. Por isso, muitos trabalhadores de países pobres tentam enganar o sistema sobre onde estão. Se são descobertos, suas contas são bloqueadas e podem até ficar sem receber seu pagamento.

Saúde mental comprometida

Eventualmente esses trabalhadores precisam rotular textos ou imagens com violência, discurso de ódio e elementos grotescos. Por isso, podem desenvolver problemas como ansiedade, depressão e estresse pós-traumático. Uma exposição prolongada a esses conteúdos pode levar ainda a uma perda de sensibilidade e de empatia.

Além dos óbvios e graves problemas para a saúde mental desses trabalhadores, a exposição contínua a dados tóxicos pode comprometer a qualidade das entregas, introduzindo vieses e discriminação nos modelos. E isso pode depois se propagar em uma sociedade que cada vez mais confia nas informações oferecidas pela IA.

As empresas que gerenciam essas plataformas precisam, portanto, oferecer suporte psicológico a esses trabalhadores e mecanismos para que eles indiquem se algo está mal. Mas isso normalmente não acontece. As big techs, por sua vez, não se importam em forçar que isso seja seguido pelas empresas que contratam.

É irônico que um negócio multibilionário tenha na sua base uma legião de anônimos trabalhando em condições tão degradantes. A sociedade deve pressionar as gigantes da tecnologia para que criem políticas de trabalho éticas e transparentes envolvendo os rotuladores de dados, e que determinem que as empresa que lhes prestem serviços cumpram essas regras. E em tempos em que se discutem leis para reger a inteligência artificial, inclusive no Brasil, esse tema não pode ficar de fora.

Sabemos que preocupações sociais nem sempre provocam mudanças em processos de produção, especialmente quando isso impactará nos seus custos. Mas se não for por isso, as empresas deveriam, pelo menos, entender que essa precarização da mão de obra implicará em produtos piores para seus clientes.

Quanto a nós, os usuários de toda essa “magia” da inteligência artificial, precisamos entender e não esquecer que, quando conversamos com o ChatGPT, aquelas respostas incríveis só são possíveis porque alguém lhe disse o que cada coisa é.