Estamos em plena volta às aulas! Com os alunos, ressurge o debate sobre como usar a tecnologia na educação, com uma inteligência artificial cada vez mais poderosa. E a prefeitura do Rio de Janeiro jogou lenha na fogueira ao proibir, na sexta passada, que os alunos usem celulares nas escolas públicas municipais, mesmo no recreio.

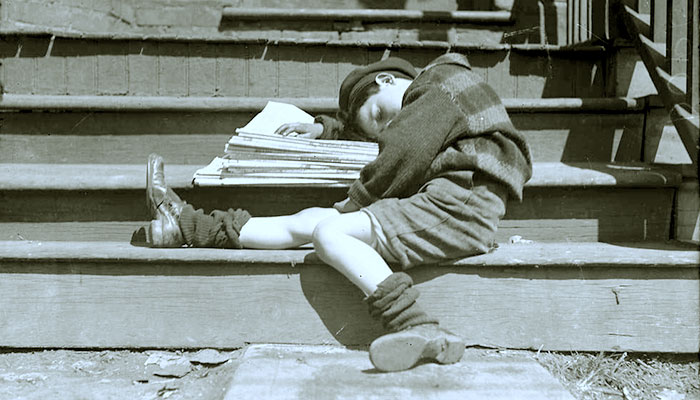

Especialistas aprovam a decisão, que tem 30 dias para ser implantada. Já debatemos longamente, nesse mesmo espaço, como os celulares em sala de aula em atividades não acadêmicas roubam a atenção dos alunos e prejudicam profundamente seu aprendizado. No caso do recreio, eles atrapalham os processos de socialização entre as crianças, necessários para o seu desenvolvimento. Pela nova regra, os equipamentos devem ficar desligados ou silenciados na mochila do estudante, podendo ser usados apenas se o professor os solicitar para alguma atividade, ou em casos excepcionais, como alunos com algum problema de saúde.

A determinação é interessante para ampliarmos o debate sobre a digitalização do ensino. Nessa mesma época, no ano passado, os professores estavam em polvorosa devido ao então recém-lançado ChatGPT. Muitos achavam que não conseguiriam mais avaliar seus alunos e alguns temiam até perderem o emprego para as máquinas.

Passado um ano, nada disso aconteceu, até porque descobrimos que essa tecnologia ainda erra muito. Mas todo aquele burburinho serviu para, pelo menos, os professores repensarem os seus processos de avaliação. Em uma sociedade altamente digitalizada, não dá mais para só pedir que alunos entreguem textos escritos em casa.

Mas se sabemos o que não deve mais ser feito, ainda não há clareza sobre como usar todo esse poder digital de maneira criativa e construtiva com os estudantes, desde a infância até a universidade. A despeito dos riscos e problemas conhecidos, os alunos devem aproveitar o que ela também oferece de bom, de forma adequada a sua idade. Essa é uma lição de casa que todos nós temos que fazer.

Veja esse artigo em vídeo:

Há 15 anos, eu trabalhava com o desenvolvimento de conteúdos didáticos digitais e sistemas de apoio pedagógico. Era uma época em que Nicholas Negroponte, fundador do Media Lab, do Massachusetts Institute of Technology (MIT), propunha o uso de notebooks de US$ 100 para crianças estudarem melhor com o apoio da tecnologia.

Essas máquinas chegaram a ser criadas e pude conhecer alguns modelos. Eram pequenas maravilhas tecnológicas para a época, a um preço convidativo. O projeto foi implantado em alguns países, mas em muitos casos (inclusive no Brasil) não evoluiu, não pela tecnologia, mas porque os professores não sabiam bem o que fazer com ela.

- Assine gratuitamente minha newsletter sobre experiência do cliente, mídia cultura e transformação digital

- Inscreva-se no meu podcast (escolha a plataforma): Spotify, Deezer, Apple Podcasts, Google Podcasts ou Soundcloud

De certa forma, vivemos algo semelhante agora. Estamos cercados por telas, e as crianças têm acesso a elas cada vez mais cedo. Segundo a pesquisa TIC Kids Online Brasil, divulgada em 25 de outubro pelo Cetic.br (órgão de pesquisa ligado ao Comitê Gestor da Internet no Brasil), 95% dos brasileiros entre 9 e 17 anos estão online, e 24% tiveram seu primeiro acesso até os seis anos de idade.

O ChatGPT popularizou a inteligência artificial, e muitas empresas correm para criar soluções educacionais com ela. Como exemplo, em maio, Salman Khan, fundador e CEO da Khan Academy, uma organização que oferece educação online gratuita, demonstrou uma ferramenta que auxilia professores e alunos. Ela não dava respostas aos estudantes, ajudando-os a pensar na solução dos problemas. Para professores, a ferramenta ajudava a planejar aulas engajadoras. Khan afirmou que, para os alunos, a IA atua como um tutor, enquanto, para os professores, age como um assistente.

Esse é um sonho antigo do Vale do Silício. Não tenho dúvidas que a tecnologia pode ajudar na educação: eu cresci com isso! Mas também sei que ela sozinha não resolve, nem mesmo a “IA tutora” de Khan. Uma educação eficiente em qualquer idade não se resume a conteúdo de qualidade ou tutores que façam provocações inteligentes. Ela depende também da humanidade dos professores, capazes de ensinar, mas também de engajar e acolher seus alunos além de suas necessidades pedagógicas.

De todo jeito, está na hora de repensarmos a educação à luz da tecnologia.

Celulares e IA como apoio

Vivemos um cenário paradoxal. Segundo a Unesco (Organização das Nações Unidas para Educação, Ciência e Cultura), o excesso de telas sem orientação prejudica a aprendizagem e até a saúde mental de crianças e adolescentes. O órgão sugere também que a IA não seja usada antes dos 13 anos de idade. Por outro lado, a ausência de tecnologia põe estudantes em desvantagem educacional.

Devemos ter cuidado para não nos deslumbrarmos com as possibilidades da tecnologia nem tampouco rechaçá-la por temor do desconhecido. Isso significa que as escolas não podem abraçar inconsequentemente uma solução como a de Khan (que tem muitos méritos), especialmente como marketing, nem demonizar as telas na sala de aula, como alguns podem entender a determinação da prefeitura do Rio de Janeiro.

Precisamos ser guiados por consciência e equilíbrio. Vimos, no ano passado, a tentativa do governo do Estado de São Paulo de abandonar os livros, que seriam substituídos por questionáveis slides produzidos pelo próprio governo. Isso sim é um uso inadequado da tecnologia, reduzindo profundamente o papel do professor.

Há muito tempo, a sociedade brasileira debate a “atualização” e a “utilidade” dos currículos escolares. E nos últimos anos, uma parcela da população aprendeu a demonizar os professores. Para esses, quanto menos professor, melhor, e a inteligência artificial poderia ser a resposta a suas preces.

Naturalmente a escola precisa estar alinhada ao nosso mundo em constante transformação. Mas devemos ter cuidado para não reduzi-la a algo meramente utilitário. A escola deve principalmente formar cidadãos conscientes e viáveis, capazes de lidar com os desafios da sociedade e melhorá-la, e isso não se faz só com a capacidade de ler ou de fazer contas: são necessárias empatia, inteligência emocional, pensamento livre e humanidade.

Quem ensina isso são os professores e o melhor lugar para uma criança e um adolescente aprenderem é a escola. A tecnologia deve ser vista como uma parceira valiosa nesse processo de transformação, não uma substituta.

Por tudo isso, tenho visto professores em algumas listas de “profissões do futuro”. Mas naturalmente serão aqueles que usam a tecnologia para ampliar seus próprios limites e os de seus alunos. O amanhã pertence a quem domine a tecnologia, sem perder nada de sua humanidade.