O sucesso explosivo do ChatGPT deu novos contornos à discussão se a inteligência artificial deve ser, de alguma forma, regulada. Com 100 milhões de usuários em apenas dois meses, a plataforma da OpenAI tornou-se o produto com adesão mais rápida da história. Sua capacidade de gerar textos convincentes sobre qualquer assunto a partir de comandos simples colocou, em polos opostos, especialistas com fortes argumentos favoráveis e contrários ao controle dessa tecnologia.

De um lado, a turma que defende a regulação aponta que tanto poder computacional poderia causar severos danos ao tomar decisões potencialmente erradas em áreas sensíveis e diversas, como a saúde, a segurança pública ou até na condução de carros autônomos. Do outro, há os que argumentam que leis assim, além de que seriam difíceis de definir e aplicar, inibiriam o desenvolvimento de uma tecnologia que pode levar os humanos a um novo patamar de produtividade. Afirmam ainda que se penalizaria os sistemas, ao invés de criminosos que fizessem maus usos deles.

O fato é que criar um regulamento para uma tecnologia tão inovadora, abrangente e poderosa quanto a inteligência artificial é mesmo um desafio. Ela se desenvolve em uma velocidade estonteante e fica difícil imaginar como qualquer legislação pode acompanhar esse ritmo e o que representaria em um futuro breve.

Veja esse artigo em vídeo:

O Senado já se debruçou sobre o tema. Entre março e dezembro de 2022, uma comissão de 18 juristas debateu o assunto com membros da academia, da sociedade civil e de empresas. Ao final, elaborou uma proposta com 45 artigos e um relatório com mais de 900 páginas, que sugere restrições ao uso de reconhecimento facial indiscriminado por câmeras e a proibição de um “ranqueamento social” com base nas ações de cada pessoa, como acontece na China. Indica ainda que fornecedores ou operadores de sistemas de “alto risco” respondam por eventuais danos que causem.

Foram analisadas legislações aprovadas entre os países da OCDE (Organização para a Cooperação e Desenvolvimento Econômico). A União Europeia pretende chegar a um consenso de projeto regulador até março. Nos Estados Unidos, um comitê consultivo, criado em abril de 2022, espera apresentar uma lei nesse ano.

- Assine gratuitamente minha newsletter sobre experiência do cliente, mídia cultura e transformação digital

- Inscreva-se no meu podcast (escolha a plataforma): Spotify, Deezer, Apple Podcasts, Google Podcasts ou Soundcloud

Mas vale dizer que tudo isso aconteceu antes do lançamento do ChatGPT, no dia 30 de novembro. E ele jogou por terra o que se sabia sobre IA para as massas. “Quando a gente fala em inteligência artificial, um dos grandes pontos sempre é como conseguir dar transparência, sem você violar a propriedade industrial ou intelectual”, explica Marcelo Crespo, coordenador do curso de Direito da ESPM (Escola Superior de Propaganda e Marketing).

Esse é um dos problemas das “inteligências artificias generativas”, como o ChatGPT. Elas produzem coisas incríveis, mas não contam de onde vieram as informações de que “aprenderam” cada tema. Também não fica claro o que acontece “debaixo do capô”, os mecanismos que lhes permitiram chegar a suas conclusões. Para Crespo, “ao invés de simplesmente dizer ‘regular’, deve ser ‘regular pensando no quê’”

Já Paulo de Oliveira Júnior, consultor de inovação e desenvolvimento do Machado Meyer Advogados, afirma que a regulamentação é essencial. “É importante para que a gente possa garantir que a tecnologia não venha a causar nenhum dano para a sociedade, seja ela no campo social, econômico ou político”, explica, concluindo que “é importante que se tenha mais previsibilidade, à medida que a tecnologia vai fazendo parte do nosso dia a dia.”

Prós e contras

Além dos motivos já citados, os defensores de uma regulamentação argumentam que ela é necessária para se ter uma garantia mínima de proteção aos dados pessoais usados pelas diferentes aplicações da inteligência artificial. Afinal, se as redes sociais já abusam de nossas informações para fazer dinheiro, com a inteligência artificial, isso ficaria ainda mais difícil de se compreender e controlar.

A legislação também seria necessária para minimizar um problema que vem incomodando em diferentes usos da IA há muitos anos: sistemas que desenvolvem vieses. Isso pode acontecer pelas informações que consome, ao incorporar preconceitos dos desenvolvedores e até aprendendo dos próprios usuários.

Curiosamente um dos argumentos daqueles que são contrários a uma regulação é que as plataformas não poderiam ser responsabilizadas por esse mau uso, e que as pessoas é que deveriam ser controladas e até punidas. Eles também afirmam que esse controle seria falho, pois suas definições seriam imprecisas, criando confusão ao invés de ajudar o mercado.

Esse é um ponto a se considerar. Diversos países do mundo, inclusive o Brasil, estão há uma década tentando regular as redes sociais, sem sucesso. Nós mesmos estamos passando por uma bem-vinda discussão sobre como minimizar os efeitos nocivos das fake news, mas ela falha no ponto essencial de definir o que é desinformação de maneira inequívoca. E isso pode, não apenas impedir os efeitos desejados, como ainda criar um mecanismo de censura.

De forma alguma, isso significa que uma regulamentação não deva ser avaliada. É exatamente o contrário: precisamos de muito debate, incluindo todos os diferentes atores da sociedade envolvidos, para que uma lei não seja criada de maneira enviesada ou incompleta. Isso, sim, seria péssimo!

Especialmente em um país como o Brasil, em que o tecido social foi esgarçado nos últimos anos pelo mau uso de plataformas digitais e onde a violência lidera as preocupações dos cidadãos, é fácil defender um discurso de “vigilantismo”. Não é disso que precisamos!

“A gente vai ter que caminhar para uma regulamentação mais abrangente, que garanta os preceitos éticos e seguros, e cada setor da economia vai ter que fazer sua regulamentação específica”, sugere Oliveira. Já Crespo traz a ideia de que cada produto de IA a ser lançado passe por uma espécie de “relatório de impacto”. “Ele incluiria o que é, quais os principais benefícios e quais os possíveis riscos embarcados, trazendo uma previsibilidade”, explica.

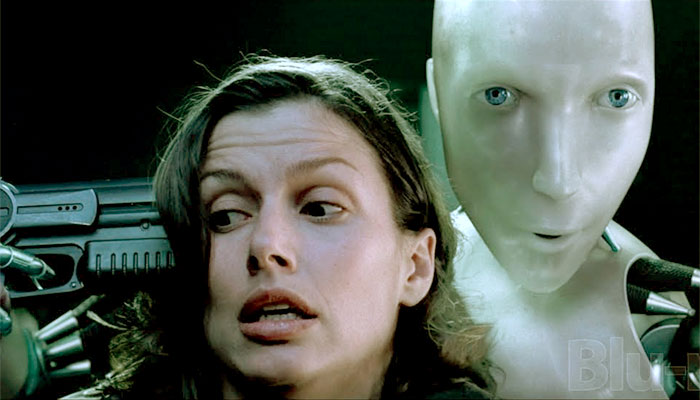

Talvez o melhor caminho seja algo assim mesmo. E a “lei geral da inteligência artificial” poderia ser as Leis da Robótica, propostas pelo escritor Isaac Asimov, em 1942. São elas: “um robô não pode ferir um ser humano ou, por inação, permitir que um ser humano sofra algum mal”, “um robô deve obedecer às ordens que lhe sejam dadas por seres humanos, exceto nos casos em que entrem em conflito com a Primeira Lei” e “um robô deve proteger sua própria existência, desde que tal proteção não entre em conflito com a Primeira ou Segunda Leis.” Mais tarde, ele acrescentou a “Lei Zero”: “um robô não pode causar mal à humanidade ou, por omissão, permitir que a humanidade sofra algum mal.”

Se conseguíssemos garantir que todas as plataformas de inteligência artificial cumprissem essas quatro diretrizes, já seria um bom começo!