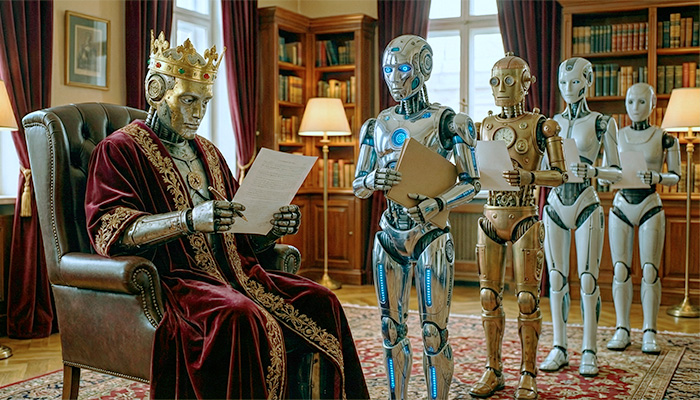

Neste ano que está começando, a inteligência artificial continuará no trono da tecnologia, mas seu reinado será muito diferente do que vimos até agora. Se nos últimos anos, ela impressionou por gerar textos, imagens e códigos, agora o debate se deslocará para a automação de decisões, a delegação de tarefas cognitivas e a reorganização do poder dentro das empresas e da sociedade, algo muito mais sensível.

Essa é a conclusão de conversas que tive com executivos de quatro das principais empresas de tecnologia que operam no Brasil. Essas lideranças apontam para um horizonte em que a “IA agêntica” não será mais uma novidade, mas um motor central de estratégias corporativas. A automação não mais se restringirá a tarefas repetitivas, passando a assumir processos cognitivos de julgamento e orquestração.

A pressão por produtividade não diminuiu, os custos de operação aumentaram e a paciência com experimentos sem retorno se esgotou. A evolução dos processadores especializados, a pressão por eficiência energética e a necessidade urgente de governança real sustentam essa visão. Por isso, as empresas buscam sistemas menores, mais inteligentes e capazes de operar dentro de casa, garantindo segurança e conformidade com leis cada vez mais rígidas.

Embora estejamos falando de tecnologia, o impacto na vida das pessoas e na rotina das empresas será profundo e, por vezes, invisível. Quando um sistema decide sozinho se concede um empréstimo, aprova um tratamento médico ou freia um carro autônomo, ele desloca o eixo da responsabilidade humana. Passamos a delegar à IA o julgamento moral e a capacidade de agir no mundo físico.

Isso nos coloca diante de um dilema que ultrapassa a engenharia e entra no campo da ética e da política. A pergunta que definirá 2026 não será, portanto, se esses sistemas serão eficientes, mas quem responderá quando eles inevitavelmente errarem.

Veja esse artigo em vídeo:

Nesse cenário, o próprio sucesso deve ser repensado. Sandra Vaz, presidente da Red Hat Brasil, afirma que “a eficiência operacional continua relevante, mas ela deixa de ser suficiente”. Para ela, em 2026, “as empresas terão de medir o impacto estratégico e ser muito criteriosas na escolha dos dados utilizados para criar novas experiências para o cliente”. Afinal, decisões ruins automatizadas em escala podem destruir o valor de uma companhia em pouco tempo.

Rui Botelho, presidente da SAP Brasil, toca exatamente nesse ponto ao projetar a consolidação de uma IA capaz de orquestrar tarefas “do fechamento financeiro à gestão de talentos, sempre com governança e rastreabilidade”. Ele destaca que o diferencial estará em “combinar essa automação com dados de negócio confiáveis”. A credibilidade torna-se, portanto, uma moeda valiosíssima nesse novo mercado.

- Assine gratuitamente minha newsletter sobre IA, experiência do cliente, mídia e transformação digital

- Inscreva-se no meu podcast (escolha a plataforma): Spotify, Deezer, Apple Podcasts ou Soundcloud

Essa transformação é descrita por Fabricio Lira, diretor de IA e Dados da IBM Brasil, como a criação de “ecossistemas onde múltiplos agentes colaboram, compreendendo dinâmicas de contexto, intenção humana e cenários complexos”. Para ele, isso permitirá “oferecer decisões autônomas e seguras em tempo real”.

Perceba que a palavra-chave é “decisão”. Estamos saindo da era da venda de software (Software as a Service) para a venda de trabalho (Service as a Software), em que a máquina entrega o resultado final, e não apenas o meio para alcançá-lo. Isso exigirá novos processos para gerenciar conflitos entre agentes e garantir que a autonomia da IA não quebre a lógica de negócios ou a segurança institucional.

Marco Stefanini, CEO Global e fundador da Stefanini, reforça essa visão, citando que “a previsão da IDC é de que 65% das empresas adotarão esses agentes até o final de 2026, com foco em valor imediato e apoio à decisão”. No entanto, ele faz um alerta fundamental sobre a natureza dessa mudança, lembrando que “IA não é mágica, é método”. “Modelos genéricos, treinados apenas com conteúdo da Internet, não dão conta da complexidade das operações corporativas”, explica.

Decisão como produto

Essas visões convergem para um cenário em que sistemas multiagentes começam a decidir em cadeia, coordenando ações, priorizando caminhos e resolvendo conflitos em tempo real. O ganho de eficiência é evidente, mas cria-se um sério risco de naturalização da delegação moral.

Se um conjunto de algoritmos toma decisões, cria-se uma zona cinzenta em que “ninguém decidiu sozinho”. Para mitigar isso, a governança deixará de ser um discurso bonito de marketing para se tornar um requisito de engenharia. Sem isso, empresas enfrentarão não apenas crises de imagem, mas barreiras legais severas.

Por trás desse debate ético e regulatório, crescerá exponencialmente uma disputa material em torno de uma tecnologia vendida como “imaterial”. A IA consome quantidades absurdas de energia e depende de escassos processadores avançados. A infraestrutura definirá o poder, e a soberania digital dos países dependerá de quem controla esses recursos.

Além das máquinas, há o desafio humano. Botelho ressalta que “nada disso se sustenta sem investimento contínuo em mão de obra qualificada”. Enquanto os agentes assumem tarefas cognitivas, os humanos precisam ser requalificados para gerenciar, auditar e corrigir essas inteligências. Vaz complementa dizendo que a tecnologia ficará mais sofisticada, com ferramentas “orientadas para a escala dos negócios e a capacitação das equipes”.

Com tudo isso, em 2026 nos depararemos com escolhas que não poderemos postergar. Precisaremos decidir quanta autonomia estamos dispostos a delegar às máquinas, como garantir que a eficiência não atropele direitos fundamentais e quem terá poder para treinar modelos em escala. A IA continuará ficando mais poderosa, mas continua valendo a máxima de que tecnologia sozinha não resolve nada.

De agora em diante, essa história exigirá menos deslumbramento e mais responsabilidade coletiva. Empresas, governos e sociedade civil precisarão construir juntos os mecanismos de supervisão, auditoria e responsabilização que ainda não existem. Não há atalho para essa maturidade, e fingir que as empresas de tecnologia se autorregularão é uma fantasia inocente e perigosa.

Ainda bem que estamos a tempo de fazer as escolhas certas.